Các Mô hình Ngôn ngữ lớn (LLM) đã và đang trở thành một phần không thể thiếu trong thế giới công nghệ, len lỏi vào internet, điện thoại thông minh và máy tính cá nhân. Từ các bộ ứng dụng văn phòng tích hợp CoPilot đến trợ lý AI trong Adobe Creative Suite, sự hiện diện của chúng ngày càng rõ nét. Tuy nhiên, việc làm việc với các LLM được lưu trữ trên đám mây đi kèm với một nhược điểm đáng kể: quyền riêng tư.

Nếu bạn là người có ý thức cao về quyền riêng tư, việc tự host (lưu trữ cục bộ) LLM có thể là một giải pháp tối ưu. Cá nhân tôi đã và đang tự host các mô hình như Llama 3 và Deepseek, điều này mang lại cho tôi khả năng kiểm soát, tùy chỉnh và tính khả dụng vượt trội. Dưới đây là bốn lý do tại sao việc tự host mô hình LLM đã thay đổi hoàn toàn cách tôi làm việc – và có thể sẽ thay đổi cả cách của bạn.

1. Quyền riêng tư và bảo mật được tăng cường

Không nên tin tưởng ChatGPT với thông tin nhạy cảm

Một trong những lý do thuyết phục nhất để tự host LLM chính là quyền riêng tư. Mặc dù không thể thay đổi việc hầu hết các LLM đã thu thập dữ liệu từ internet và được đào tạo trên thông tin công khai, nhưng tôi không ủng hộ việc cung cấp thêm dữ liệu cá nhân của mình cho chúng. Khi làm việc với các tài liệu mật hoặc phân tích hồ sơ sức khỏe cá nhân, việc tải chúng lên ChatGPT hoàn toàn không phải là một lựa chọn. Vấn đề không chỉ nằm ở dữ liệu được thu thập; đó là vấn đề về quyền kiểm soát. Càng giữ được thông tin cá nhân của mình khỏi đám mây, tôi càng cảm thấy an tâm hơn.

Việc chạy LLM cục bộ cho phép tôi thực hiện nhiều chức năng tương tự mà không cần cấp quyền truy cập vào thông tin riêng tư của mình cho mục đích đào tạo mô hình. Thậm chí, bạn có thể ngắt kết nối internet và LLM tự host vẫn hoạt động trơn tru. Mức độ kiểm soát quyền riêng tư này là vô giá, đặc biệt đối với những người thường xuyên xử lý tài liệu nhạy cảm. Hơn nữa, việc lưu trữ mô hình cục bộ giúp giảm thiểu khả năng chia sẻ dữ liệu không mong muốn.

2. Khả năng truy cập mọi lúc mọi nơi

Điều mà các LLM đám mây khó lòng làm được

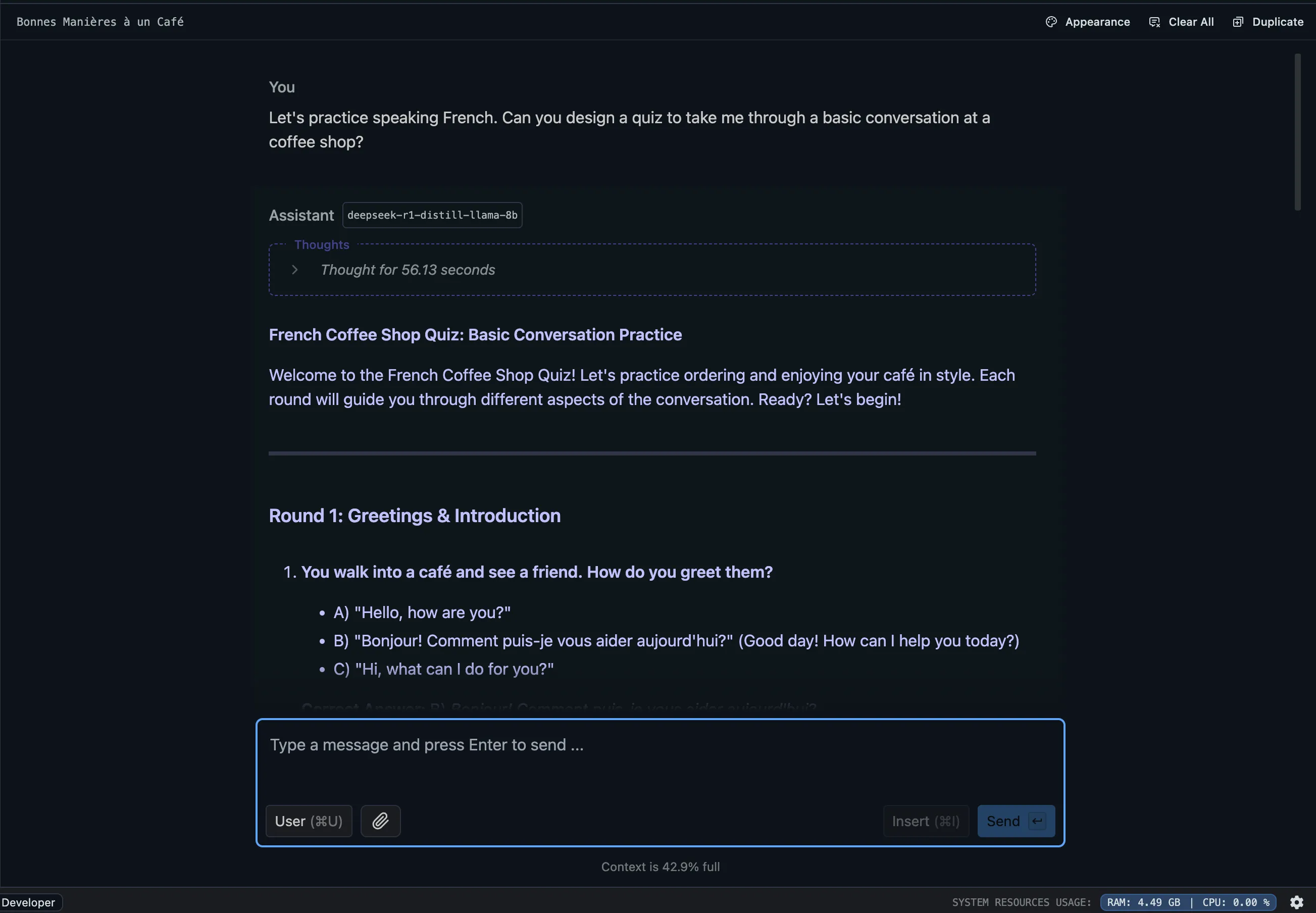

Giao diện LM Studio hiển thị kết quả luyện tập tiếng Pháp, minh họa khả năng sử dụng LLM cục bộ khi ngoại tuyến

Giao diện LM Studio hiển thị kết quả luyện tập tiếng Pháp, minh họa khả năng sử dụng LLM cục bộ khi ngoại tuyến

Điều này dẫn tôi đến luận điểm tiếp theo – tính di động. Dù ChatGPT và Claude có tốt đến mấy, chúng chỉ có thể được sử dụng khi bạn có kết nối Wi-Fi. Điều gì sẽ xảy ra nếu bạn đang làm việc trên chuyến bay, hoặc trên một chuyến tàu với kết nối kém ổn định? Hay ở một quán cà phê với internet chập chờn? Đó là những trường hợp không thể sử dụng.

Đây chính là lúc tự host thực sự tỏa sáng. Chẳng hạn, tuần trước, tôi đã khởi động mô hình Deepseek 7B trên MacBook Air của mình trong một chuyến bay để động não ý tưởng cho một bài thuyết trình. Chắc chắn, nó không nhanh bằng việc truy cập một LLM trên đám mây, nhưng tôi không quá bận tâm đến vài giây chờ đợi thêm để lên ý tưởng, kiểm tra ngữ pháp hay ôn lại một ngôn ngữ nào đó.

Vẻ đẹp của việc lưu trữ cục bộ là tôi không phụ thuộc vào kết nối bên ngoài để hoàn thành công việc. Đó thực sự là một sự thay đổi lớn.

3. Tiết kiệm chi phí hiệu quả

Gánh nặng phí đăng ký đang là vấn đề

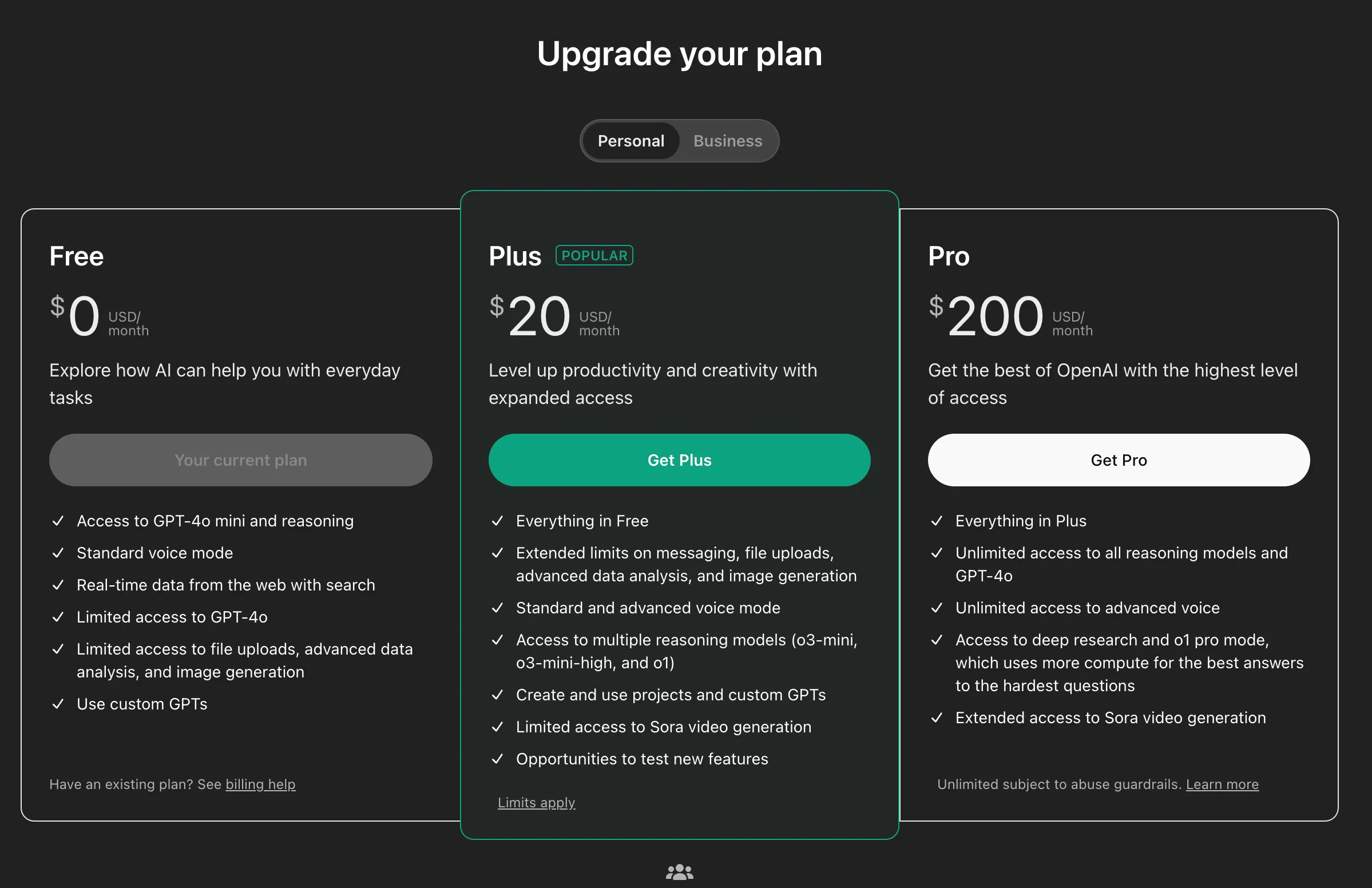

Biểu đồ hoặc hình ảnh minh họa chi phí liên quan đến mô hình ngôn ngữ lớn, làm nổi bật lợi ích tiết kiệm khi tự host LLM

Biểu đồ hoặc hình ảnh minh họa chi phí liên quan đến mô hình ngôn ngữ lớn, làm nổi bật lợi ích tiết kiệm khi tự host LLM

Hãy thành thật mà nói, không ai muốn trả tiền cho thêm một dịch vụ đăng ký nào nữa. Dù gói cao cấp của ChatGPT có tốt đến đâu, hầu hết những gì tôi cần từ một LLM cá nhân đều không yêu cầu chi phí bổ sung đó. Việc tự host mô hình của riêng mình đã vô cùng tiết kiệm chi phí, và nếu trường hợp sử dụng của bạn không quá phức tạp, đây có thể là lựa chọn phù hợp cho bạn – đặc biệt khi mọi thứ trở nên dễ dàng với các công cụ như LM Studio.

Mặc dù các gói cao cấp của các dịch vụ như ChatGPT có thể mang lại hiệu suất tốt hơn, chúng thường không cần thiết cho hầu hết các tác vụ hàng ngày. Việc chạy mô hình của riêng tôi giúp loại bỏ hoàn toàn các khoản phí đăng ký đó, điều này đối với tôi là một thắng lợi lớn. Hơn nữa, sự sẵn có của các mô hình hiệu quả về tài nguyên như Llama 3 và Deepseek càng khiến nó trở thành một lựa chọn hấp dẫn hơn.

Chắc chắn, bạn sẽ không thể chạy các mô hình đầy đủ (full-fledged models) trên máy tính cá nhân. Tuy nhiên, theo kinh nghiệm của tôi, các mô hình đã được lượng tử hóa (quantized models) vẫn mang lại đủ tiện ích cho các mục đích sử dụng hàng ngày.

4. Cơ hội học hỏi và tùy chỉnh không giới hạn

Tinh chỉnh mô hình AI theo sở thích cá nhân

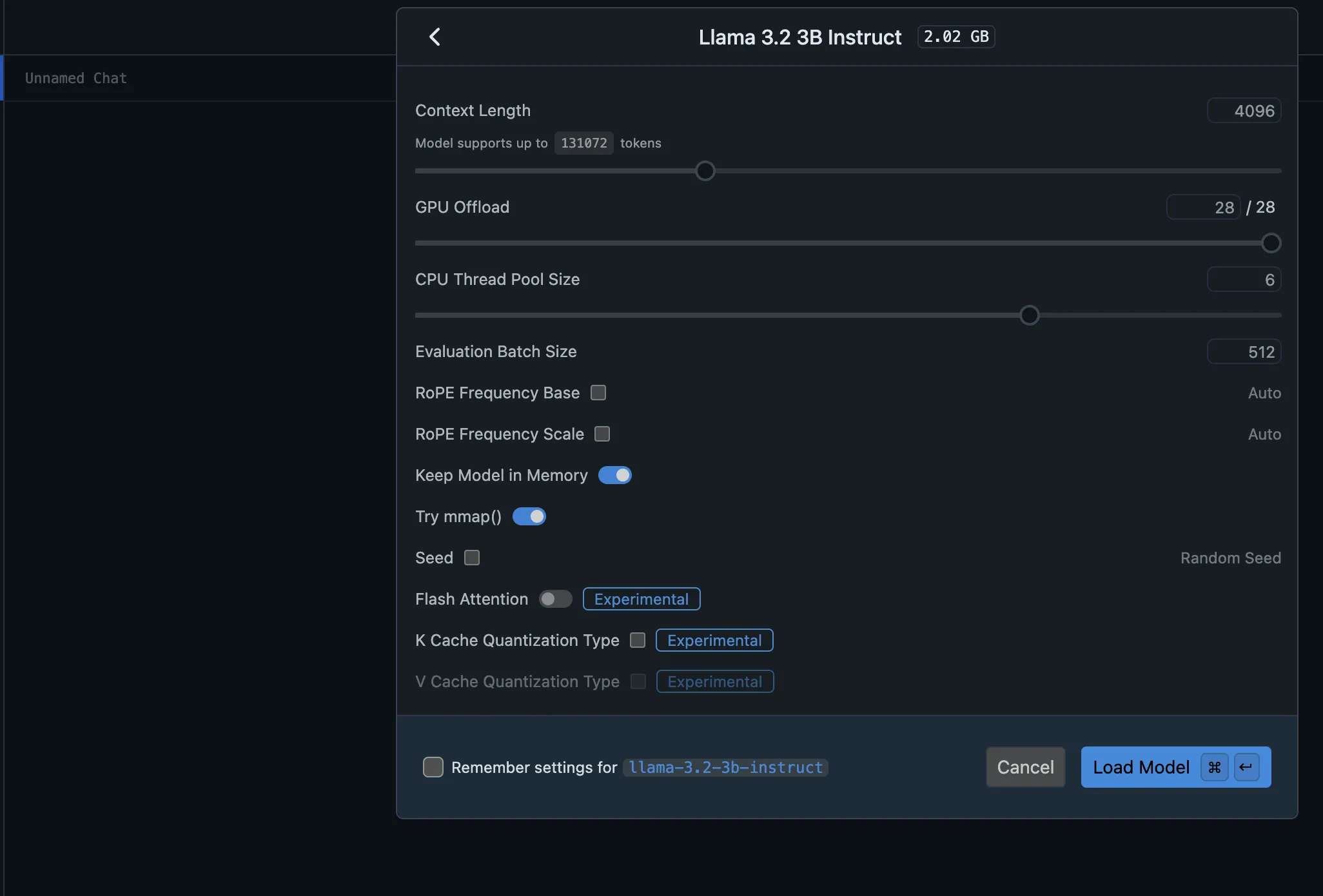

Giao diện LM Studio đang tải mô hình Llama 3, minh họa quá trình tùy chỉnh và thử nghiệm LLM cục bộ

Giao diện LM Studio đang tải mô hình Llama 3, minh họa quá trình tùy chỉnh và thử nghiệm LLM cục bộ

Đây là lúc mọi thứ trở nên thú vị hơn. Với tư cách là một người đam mê công nghệ, việc đi sâu vào từng ngóc ngách của mọi thứ là điều tự nhiên đối với tôi. Tôi thích hiểu cách mọi thứ hoạt động bên trong, và việc tự host một LLM đã mang lại cho tôi cơ hội đó. Tự host LLM cho phép tôi thử nghiệm và tối ưu hóa nó cho các trường hợp sử dụng cụ thể của mình – dù là phân tích dữ liệu, trò chuyện hay tạo nội dung. Tôi không phải lúc nào cũng thành công với mỗi lần điều chỉnh, nhưng đó là một cách tuyệt vời để tìm hiểu cách các mô hình này hoạt động và định hình chúng theo nhu cầu của tôi.

Tự host mang lại mức độ tùy chỉnh không thể sánh bằng. Thay vì bị giới hạn bởi các tùy chọn cài đặt sẵn do dịch vụ đám mây cung cấp, tôi có thể điều chỉnh hành vi của LLM để phù hợp hơn với yêu cầu của mình. Điều này có thể là thay đổi tông giọng đàm thoại của nó, tối ưu hóa nó cho các tác vụ cụ thể hoặc tích hợp nó với các công cụ tôi sử dụng hàng ngày. Khả năng linh hoạt để thử nghiệm và phát triển mô hình là điều tôi thực sự yêu thích. Phải thừa nhận rằng, điều này không hoạt động trên thiết bị trừ khi bạn có phần cứng cực kỳ mạnh mẽ. Nhưng tôi đã thử nghiệm tinh chỉnh các mô hình bằng Amazon Sagemaker.

Ngoài ra, tôi đã dành thời gian xây dựng các công cụ kết nối với API của Deepseek để phân tích các khoản đầu tư cá nhân và dữ liệu sức khỏe của mình. Mặc dù tôi sẽ không thoải mái khi gửi dữ liệu này đến một máy chủ đám mây, việc có quyền truy cập cục bộ cho phép tôi “mò mẫm” và điều chỉnh mô hình LLM để phù hợp hơn với trường hợp sử dụng của mình. Cách tiếp cận thực hành này vừa mang tính giáo dục vừa mang lại nhiều phần thưởng. Tôi đã xây dựng các tập lệnh tùy chỉnh, khám phá các chức năng mới và tinh chỉnh mô hình để nó cung cấp chính xác những gì tôi cần. Cảm giác kiểm soát đó là vô giá.

Tóm lại, việc tự host LLM đã thay đổi cuộc chơi đối với tôi, mang lại mức độ kiểm soát, quyền riêng tư và tùy chỉnh mà các mô hình dựa trên đám mây không thể sánh được. Nó không hoàn hảo – có những đánh đổi đáng kể về tốc độ, sự tiện lợi và thường là độ chính xác, đặc biệt khi thực hiện nghiên cứu chuyên sâu. Tuy nhiên, khả năng thử nghiệm, bảo vệ dữ liệu và có một AI thực sự hoạt động theo ý mình đã làm cho tất cả đều xứng đáng. Nếu bạn là người coi trọng quyền riêng tư, thích vọc vạch công nghệ hoặc chỉ muốn một trải nghiệm AI cá nhân hóa hơn, tự host có thể là lựa chọn hoàn hảo dành cho bạn.